Verwenden Sie zu Logging-Zwecken das Vertex AI SDK für Python.

Unterstützte Messwerte und Parameter:

- Zusammenfassende Messwerte

- Zeitachsenmesswerte

- Parameter

- Klassifizierungsmesswerte

Vertex AI SDK für Python

Hinweis: Wenn der optionale Parameter resume als TRUE angegeben ist, wird die zuvor gestartete Ausführung fortgesetzt. Wenn keine Angabe erfolgt, wird resume standardmäßig auf FALSE gesetzt und eine neue Ausführung erstellt.

Im folgenden Beispiel wird die Methode init aus den aiplatform-Funktionen verwendet.

Zusammenfassende Messwerte

Zusammenfassende Messwerte sind skalare Messwerte, die neben Zeitachsenmesswerten gespeichert werden und die abschließende Zusammenfassung eines Testlaufs darstellen.

Ein Beispiel für einen Anwendungsfall ist das frühzeitige Anhalten, wenn eine Geduldkonfiguration das Training fortsetzen kann, das Kandidatenmodell jedoch aus einem früheren Schritt wiederhergestellt wird und die für dieses Modell berechneten Messwerte in diesem Schritt als zusammenfassender Messwert dargestellt werden. Dies liegt daran, dass der neueste Zeitachsenmesswert nicht repräsentativ für das wiederhergestellte Modell ist. Zu diesem Zweck wird die log_metrics API für zusammengefasste Messwerte verwendet.

Python

experiment_name: Geben Sie einen Namen für den Test an. Um die Liste der Experimente in der Google Cloud Console aufzurufen, wählen Sie Tests im Navigationsbereich aus.run_name: Geben Sie einen Ausführungsnamen an (siehestart_run).metric: Messwert-Schlüssel/Wert-Paare. Zum Beispiel{'learning_rate': 0.1}.project: Ihre Projekt-ID. Sie finden die Projekt-ID auf der Begrüßungsseite der Google Cloud Console.location: Siehe Liste der verfügbaren Standorte.

Zeitachsenmesswerte

Für das Logging von Zeitachsenmesswerten ist für Vertex AI Experiments eine unterstützende Vertex AI TensorBoard-Instanz erforderlich.

Weisen Sie Vertex AI TensorBoard-Sicherungsressourcen für Zeitachsenmesswert zu.

Alle über log_time_series_metrics protokollierten Messwerte werden als Zeitachsenmesswerte gespeichert.

Vertex AI TensorBoard ist der unterstützende Speicher für Zeitachsenmesswerte.

experiment_tensorboard kann sowohl auf Testebene als auch auf Testausführungsebene festgelegt werden. Wenn Sie das experiment_tensorboard auf Ausführungsebene festlegen, wird die Einstellung auf Testebene überschrieben. Sobald das experiment_tensorboard in einer Ausführung festgelegt wurde, kann das experiment_tensorboard der Ausführung nicht mehr geändert werden.

- Legen Sie

experiment_tensorboardauf Testebene fest:aiplatform.

init(experiment='my-experiment', experiment_tensorboard='projects/.../tensorboard/my-tb-resource') - Legen Sie

experiment_tensorboardauf Ausführungsebene fest: Hinweis: Überschreibt die Einstellung auf Testebene.aiplatform.

start_run(run_name='my-other-run', tensorboard='projects/.../.../other-resource') aiplatform.log_time_series_metrics(...)

Python

experiment_name: Geben Sie den Namen Ihres Tests an. Um die Liste der Experimente in der Google Cloud Console aufzurufen, wählen Sie Tests in der Abschnittsnavigation aus.run_name: Geben Sie einen Ausführungsnamen an (siehestart_run).metrics: Wörterbuch, in dem Schlüssel Messwertnamen und Werte Messwerte sind.step: Optional. Schrittindex dieses Datenpunkts innerhalb der Ausführung.wall_time: Optional. Uhrzeit-Zeitstempel, wenn dieser Datenpunkt vom Endnutzer generiert wird. Wenn nicht angegeben, wirdwall_timebasierend auf dem Wert von time.time() generiert.project: Ihre Projekt-ID. Sie finden die Projekt-ID auf der Begrüßungsseite der Google Cloud Console.location: Siehe Liste der verfügbaren Standorte.

Schritt und Walltime

Die log_time_series_metrics-API akzeptiert optional step und walltime.

step: Optional. Schrittindex dieses Datenpunkts innerhalb der Ausführung. Wenn nicht angegeben, wird ein Inkrement über dem letzten Schritt unter allen bereits protokollierten Zeitachsenmesswerten verwendet. Wenn der Schritt für einen der bereitgestellten Messwertschlüssel vorhanden ist, wird der Schritt überschrieben.wall_time: Optional. Die Sekunden nach der Epoche des protokollierten Messwerts. Wenn dies nicht angegeben ist, gilt standardmäßigtime.timevon Python.

Beispiel:

aiplatform.log_time_series_metrics({"mse": 2500.00, "rmse": 50.00})

Für einen bestimmten Schritt protokollieren

aiplatform.log_time_series_metrics({"mse": 2500.00, "rmse": 50.00}, step=8)

wall_time einschließen

aiplatform.log_time_series_metrics({"mse": 2500.00, "rmse": 50.00}, step=10)

Parameter

Parameter sind Schlüsseleingabewerte, die eine Ausführung konfigurieren, das Verhalten der Ausführung steuern und die Ergebnisse der Ausführung beeinflussen. Beispiele sind die Lernrate, die Abbruchrate und die Anzahl der Trainingsschritte. Parameter mit der Methode log_params protokollieren

Python

aiplatform.log_params({"learning_rate": 0.01, "n_estimators": 10})

experiment_name: Geben Sie einen Namen für den Test an. Um die Liste der Experimente in der Google Cloud Console aufzurufen, wählen Sie Tests in der Abschnittsnavigation aus.run_name: Geben Sie einen Ausführungsnamen an (siehestart_run).params: Schlüssel/Wert-Paare für Parameter. Beispiel:{'accuracy': 0.9}(siehelog_params). Begrüßungsseite.location: Siehe Liste der verfügbaren Standorte.

Klassifizierungsmesswerte

Zusätzlich zu den zusammenfassenden Messwerten und Zeitachsenmesswerten werden Wahrheitsmatrizen und ROC-Kurven häufig verwendet. Sie können mithilfe der log_classification_metrics API in Vertex AI Experiments protokolliert werden.

Python

experiment_name: Geben Sie einen Namen für den Test an. Um die Liste der Experimente in der Google Cloud Console aufzurufen, wählen Sie Tests im Navigationsbereich aus.run_name: Geben Sie einen Ausführungsnamen an (siehestart_run).project: Ihre Projekt-ID. Sie finden die Projekt-ID auf der Begrüßungsseite der Google Cloud Console.location: Siehe Liste der verfügbaren Standorte.labels: Liste der Labelnamen für die Wahrheitsmatrix. Muss festgelegt werden, wenn "matrix" festgelegt ist.matrix: Werte für die Wahrheitsmatrix. Muss festgelegt werden, wenn "labels" festgelegt ist.fpr: Liste der falsch positiven Werte für die ROC-Kurve. Muss festgelegt werden, wenn "tpr" oder "thresholds" festgelegt ist.tpr: Liste der richtig positiven Werte für die ROC-Kurve. Muss festgelegt werden, wenn "fpr“ oder "thresholds" festgelegt ist.threshold: Liste der Schwellenwerte für die ROC-Kurve. Muss festgelegt werden, wenn "fpr" oder "tpr" festgelegt ist.display_name: Der benutzerdefinierte Name für das Artefakt des Klassifizierungsmesswerts.

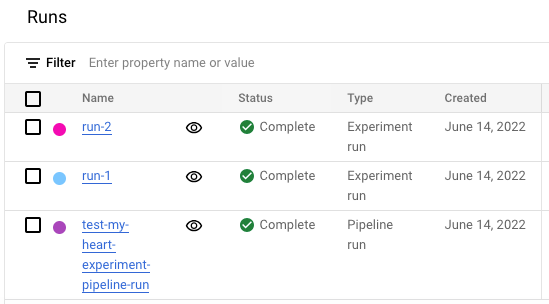

Liste der Testausführungen in der Google Cloud Console anzeigen

- Rufen Sie in der Google Cloud Console die Seite Tests auf.

<a{: class="button button-primary" l10n-attrs-original-order="href,target,class,track-name,track-type" l10n-encrypted-href="V3Ae1hvcBOij4KvUNiRrMltigmNHgUGOXn/QVSGplOhBlpxunv8WHL3F/z3VuS9rwbZOYpOQCXa+v4aZ0dt03w==" target="console" track-name="consoleLink" track-type="tasks" }="">Go to Experiments

Eine Liste der Tests wird angezeigt. </a{:> - Wählen Sie den Test aus, den Sie prüfen möchten.

Es wird eine Liste der Ausführungen angezeigt.

Weitere Informationen finden Sie unter Ausführungen vergleichen und analysieren.