Pour qu'un modèle puisse être suivi, partagé et analysé facilement, le SDK Vertex AI pour Python fournit une API qui sérialise un modèle de machine learning dans une classe ExperimentModel et le consigne dans Vertex AI Experiments.

Après avoir choisi le meilleur modèle à utiliser, vous pouvez l'enregistrer depuis Vertex AI Experiments vers Vertex AI Model Registry.

Les frameworks compatibles sont scikit-learn, XGBoost et TensorFlow.

Enregistrer et journaliser le modèle de ML

Enregistrer les modèles

Le SDK Vertex AI fournit la méthode save_model pour sérialiser un modèle de ML, importer le modèle dans Cloud Storage, et le représenter en tant qu'artefact Vertex ML Metadata.

Python

project: l'ID de votre projet. Vous pouvez trouver ces ID sur la page Accueil de la console Google Cloud.location: consultez la liste des emplacements disponibles.model: (Obligatoire). Modèle de machine learning.(Union["sklearn.base.BaseEstimator", "xgb.Booster", "tf.Module"])artifact_id: facultatif. ID de ressource de l'artefact. Cet ID doit être unique dans un magasin de métadonnées. Il peut contenir jusqu'à 63 caractères et les caractères valides sont[a-z0-9_-]. Le premier caractère ne peut pas être un chiffre ni un trait d'union.uri: facultatif. Répertoire gcs dans lequel enregistrer le fichier de modèle. Si aucun URI n'est fourni,gs://default-bucket/timestamp-uuid-frameworkName-modelest utilisé. Si aucun bucket de préproduction par défaut n'est défini, un bucket est créé.input_example: facultatif. Chaque modèle prend des données d'entrée, puis produit une prédiction. Chaque modèle accepte un format d'entrée particulier (par exemple, un nombre, une chaîne, un tableau 2D) et est stocké sous forme de fichier yaml dans l'URI gcs. Accepte les paramètres "list", "dict", "pd.DataFrame" et "np.ndarray". La valeur d'une liste doit être de type scalaire ou liste. La valeur dans un dictionnaire doit être de type scalaire, liste ou np.ndarray.(Union[list, dict, pd.DataFrame, np.ndarray]).display_name: Nom à afficher de l'artefact.

Modèles de journaux

Le SDK Vertex AI fournit une méthode log_model, qui orchestre save_model et une étape supplémentaire pour consigner l'artefact Vertex ML Metadata dans l'exécution du test en cours. La méthode log_model pour gérer et analyser plusieurs modèles de ML dans Vertex AI Experiments.

Python

experiment_name: indiquez le nom de votre test. Vous trouverez la liste de vos tests dans la console Google Cloud en sélectionnant "Tests" dans la section de navigation.run_name: spécifiez un nom d'exécution.project: l'ID de votre projet. Vous pouvez trouver ces ID sur la page d'accueil de la console Google Cloud.location: Consultez la liste des emplacements disponibles.model: valeur obligatoire. Modèle de machine learning.(Union["sklearn.base.BaseEstimator", "xgb.Booster", "tf.Module"])uri: facultatif. Répertoire gcs dans lequel enregistrer le fichier de modèle. Si aucun URI n'est fourni,gs://default-bucket/timestamp-uuid-frameworkName-modelest utilisé. Si aucun bucket de préproduction par défaut n'est défini, un bucket est créé.input_example: facultatif. Chaque modèle prend des données d'entrée, puis produit une prédiction. Chaque modèle accepte un format d'entrée particulier (par exemple, un nombre, une chaîne, un tableau 2D) et est stocké sous forme de fichier yaml dans l'URI gcs. Accepte les paramètres "list", "dict", "pd.DataFrame" et "np.ndarray". La valeur d'une liste doit être de type scalaire ou liste. La valeur dans un dictionnaire doit être de type scalaire, liste ou np.ndarray.(Union[list, dict, pd.DataFrame, np.ndarray]).display_name: facultatif. Nom à afficher de l'artefact.

Suivre ExperimentModel

Obtenir le modèle de test

Pour renvoyer un modèle enregistré à l'aide de get_experiment_model, transmettez-lui l'ID d'artefact du modèle enregistré.

Python

project: l'ID de votre projet. Vous pouvez trouver ces ID sur la page d'accueil de la console Google Cloud.location: Consultez la liste des emplacements disponibles.artifact_id: obligatoire : ID de ressource du modèle existant.

Obtenir des modèles de test

La méthode get_experiment_models permet d'obtenir la liste de toutes les instances ExperimentModel qui sont enregistrées dans une exécution de test particulière.

Python

run_name: spécifiez un nom d'exécution.experiment: indiquez le nom de votre test. Vous trouverez la liste de vos tests dans la console Google Cloud en sélectionnant "Tests" dans le menu de navigation.project: l'ID de votre projet. Vous pouvez trouver ces ID sur la page d'accueil de la console Google Cloud.location: Consultez la liste des emplacements disponibles.

Obtenir des informations sur le modèle

La méthode get_model_info renvoie les métadonnées de modèle d'une instance ExperimentModel donnée, par exemple la classe de modèle ou le type de framework.

Python

artifact_id: obligatoire : ID de ressource de l'instanceExperimentModelexistante.project: l'ID de votre projet. Vous pouvez trouver ces ID sur la page d'accueil de la console Google Cloud.location: Consultez la liste des emplacements disponibles.

Charger ExperimentModel

Charger le modèle

La méthode load_experiment_model vous permet de désérialiser une instance ExperimentModel dans le modèle de ML d'origine.

Python

artifact_id: (Obligatoire). ID de ressource de l'instanceExperimentModelexistante. Exemple :artifact_id="my-sklearn-model"project: l'ID de votre projet. Vous pouvez trouver ces ID sur la page d'accueil de la console Google Cloud.location: Consultez la liste des emplacements disponibles.

Enregistrer ExperimentModel

Enregistrer le modèle sauvegardé

L'API register_experiment_model permet d'enregistrer le modèle qui a été considéré comme le meilleur dans Vertex AI Model Registry avec une configuration minimale. L'API choisit automatiquement un conteneur de prédiction prédéfini en fonction du framework et de la version du modèle.

Python

artifact_id: (Obligatoire). ID de ressource de l'instanceExperimentModelexistante.project: l'ID de votre projet. Vous pouvez trouver ces ID sur la page d'accueil de la console Google Cloud.location: Consultez la liste des emplacements disponibles.display_name: facultatif. Nom défini par l'utilisateur du modèle enregistré.

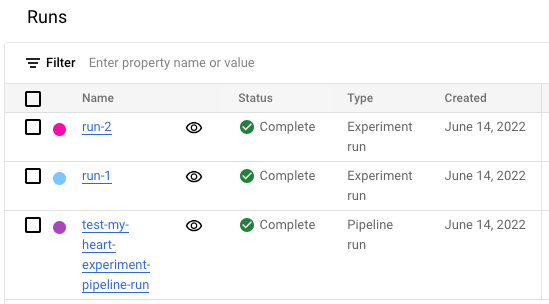

Afficher la liste des exécutions de tests dans la console Google Cloud

- Dans la console Google Cloud, accédez à la page Tests.

<a{: class="button button-primary" l10n-attrs-original-order="href,target,class,track-name,track-type" l10n-encrypted-href="V3Ae1hvcBOij4KvUNiRrMltigmNHgUGOXn/QVSGplOhBlpxunv8WHL3F/z3VuS9rwbZOYpOQCXa+v4aZ0dt03w==" target="console" track-name="consoleLink" track-type="tasks" }="">Accéder à la page Tests

Une liste de tests s'affiche. </a{:> - Sélectionnez le test que vous souhaitez vérifier.

Une liste des exécutions s'affiche.