Introduction

Cette page offre un bref aperçu des concepts et méthodes d'attribution de caractéristiques disponibles avec Vertex AI. Pour une présentation technique plus détaillée, consultez notre livre blanc sur AI Explanations.

L'importance des caractéristiques globales (attributions des caractéristiques du modèle) indique l'impact de chaque caractéristique sur un modèle. Les valeurs sont fournies sous la forme d'un pourcentage pour chaque caractéristique : plus le pourcentage est élevé, plus l'impact de la caractéristique sur l'entraînement du modèle est important. Pour afficher l'importance des caractéristiques globales de votre modèle, examinez les métriques d'évaluation.

Les attributions de caractéristiques locales pour les modèles de séries temporelles indiquent dans quelle mesure chaque caractéristique issue des données a contribué au résultat prédit. Vous pouvez ensuite exploiter ces informations pour vérifier que votre modèle se comporte comme prévu, identifier les biais dans vos modèles et obtenir des idées pour améliorer votre modèle et vos données d'entraînement. Lorsque vous demandez des prédictions, vous obtenez des valeurs prédites correspondant à votre modèle. Lorsque vous demandez des explications, vous obtenez les prédictions ainsi que les informations d'attribution des caractéristiques.

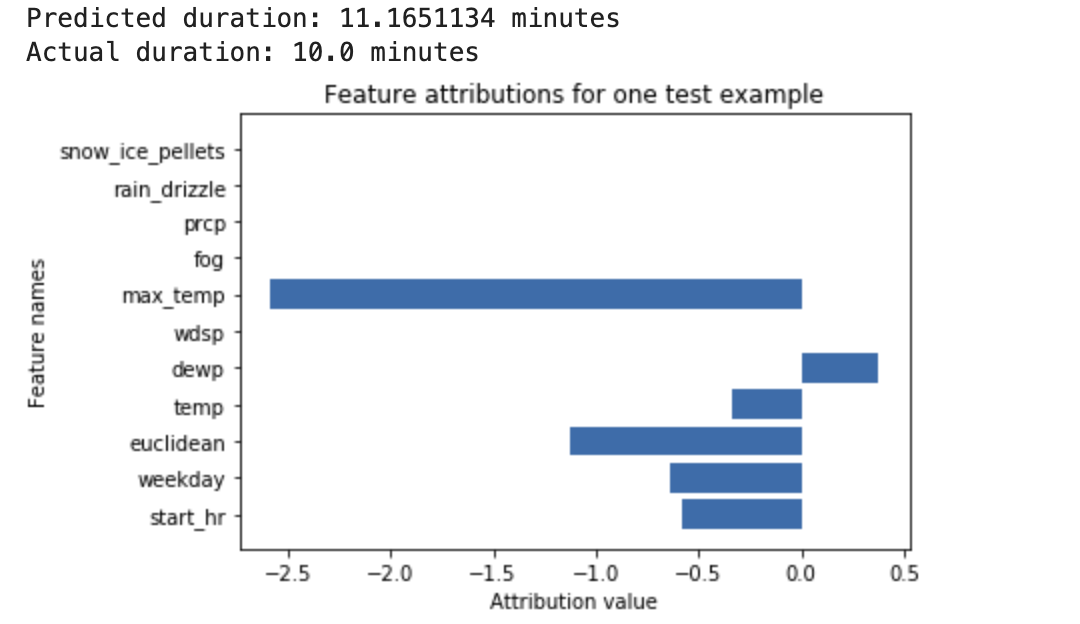

Prenons l'exemple suivant : un réseau de neurones profond est entraîné pour prédire la durée d'un trajet à vélo, en fonction des données météorologiques et des données de trajets précédents fournies par les stations de vélos en libre-service. Si vous ne demandez que des prédictions à partir de ce modèle, vous obtenez la durée prévue des trajets à vélo en minutes. Si vous demandez des explications, vous obtenez la durée prévue des trajets à vélo, ainsi qu'un score d'attribution pour chaque caractéristique dans votre requête d'explication. Les scores d'attribution indiquent dans quelle mesure chaque caractéristique a affecté la variation de la valeur de prédiction par rapport à la valeur de référence que vous avez spécifiée. Choisissez une valeur de référence cohérente et adaptée à votre modèle, en l'occurrence la durée moyenne d'un trajet à vélo.

Vous pouvez tracer les scores d'attribution des caractéristiques pour identifier celles qui ont le plus contribué à la prédiction obtenue :

Vous pouvez générer et interroger des attributions de caractéristiques locales lorsque vous effectuez une tâche de prédiction en ligne ou de prédiction par lot.

Avantages

Si vous inspectez des instances spécifiques et regroupez les attributions de caractéristiques dans votre ensemble de données d'entraînement, vous pouvez obtenir des insights plus complets sur le fonctionnement de votre modèle. Tenez compte des avantages suivants :

Déboguer les modèles : les attributions de caractéristiques peuvent aider à détecter les problèmes liés aux données que les techniques d'évaluation standards des modèles ne parviennent généralement pas à résoudre.

Optimiser les modèles : vous pouvez identifier et supprimer les caractéristiques moins importantes, ce qui permet d'obtenir des modèles plus efficaces.

Limites conceptuelles

Les attributions de caractéristiques comportent les limites suivantes dont vous devez tenir compte :

Les attributions de caractéristiques, y compris l'importance des caractéristiques locales pour AutoML, sont spécifiques aux prédictions individuelles. Si inspecter les attributions de caractéristiques pour une prédiction individuelle permet d'obtenir des informations utiles, elles ne sont pas forcément généralisables à l'ensemble de la classe ou du modèle.

Pour obtenir des informations plus générales sur les modèles AutoML, reportez-vous à l'importance des caractéristiques du modèle. Pour obtenir des insights plus généralisables à d'autres modèles, vous pouvez agréger les attributions dans des sous-ensembles de votre ensemble de données, ou our l'ensemble de données complet.

Chaque attribution indique uniquement dans quelle mesure la caractéristique a contribué à la prédiction pour cet exemple particulier. Une attribution particulière peut ne pas refléter le comportement global du modèle. Pour comprendre le comportement approximatif du modèle sur un ensemble de données, agrégez les attributions sur cet ensemble.

Bien que les attributions de caractéristiques puissent faciliter le débogage du modèle, elles n'indiquent pas toujours clairement si un problème provient du modèle lui-même ou des données sur lesquelles il est entraîné. Faites appel à votre bon sens et analysez les problèmes de données courants afin de réduire le champ des causes potentielles.

Les attributions dépendent entièrement du modèle et des données utilisées pour l'entraîner. Elles se bornent à faire apparaître les motifs que le modèle a trouvés dans les données sans pouvoir détecter de relations fondamentales au sein des données. La présence ou l'absence d'une attribution prononcée à une certaine caractéristique ne signifie pas qu'il existe ou non une relation entre cette caractéristique et la cible. L'attribution indique simplement que le modèle utilise ou non la caractéristique pour effectuer ses prédictions.

Les attributions ne peuvent pas à elles seules indiquer si votre modèle est équitable, dépourvu de biais ou de bonne qualité. En plus des attributions, vous devez évaluer avec soin vos données d'entraînement et vos métriques d'évaluation.

Pour en savoir plus sur les limites, consultez le livre blanc sur AI Explanations.

Améliorer les attributions de caractéristiques

Les facteurs qui influent le plus sur les attributions de caractéristiques sont les suivants :

- Les méthodes d'attribution fonctionnent par approximation des valeurs de Shapley. Vous pouvez augmenter la précision de l'approximation en augmentant le nombre de chemins pour la méthode d'échantillonnage de valeurs de Shapley. Cela pourrait radicalement changer les attributions.

- Les attributions n'indiquent que l'effet de la caractéristique sur la variation de la valeur de prédiction par rapport à la valeur de référence. Veillez à choisir une référence pertinente en fonction de la question que vous posez au modèle. Les valeurs d'attribution et leur interprétation peuvent changer de manière significative lorsque vous changez de référence.

Algorithm

Vertex AI fournit des attributions de caractéristiques à l'aide des valeurs de Shapley, un algorithme collaboratif issu de la théorie des jeux qui attribue un crédit à chaque joueur pour un résultat particulier. Appliqué aux modèles de machine learning, cela signifie que chaque caractéristique de modèle est traitée comme un "joueur" dans le jeu, et que le crédit est attribué proportionnellement au résultat d'une prédiction particulière. Pour les modèles de données structurées, Vertex AI utilise une approximation d'échantillonnage de valeurs de Shapley exactes nommée Échantillonnage des valeurs de Shapley.

Pour des informations détaillées sur le fonctionnement de la méthode d'échantillonnage des valeurs de Shapley, consultez l'article Bounding the Estimation Error of Sampling-based Shapley Value Approximation (Limiter l'erreur d'estimation de l'approximation d'échantillonnage basée sur les valeurs de Shapley).

Étapes suivantes

Les ressources pédagogiques suivantes vous seront également utiles :

- Interpretable Machine Learning: Shapley values (Modèles de machine learning interprétables : les valeurs de Shapley)

- Présentation des valeurs de Shapley