Vertex AI SDK for Python を使用して、Vertex AI Experiments の実行データを表示し、実行を比較できます。

Google Cloud コンソールには、これらの実行に関連するデータを可視化するための機能が用意されています。

テスト実行データを取得する

これらのサンプルには、特定のテスト実行の実行指標、実行パラメータ、ランタイム シリーズの指標、アーティファクト、分類指標の取得が含まれます。

サマリー指標

Python

run_name: このセッションの適切な実行名を指定します。experiment: このテストの名前またはインスタンス。Google Cloud コンソールで、セクション ナビゲーションの [テスト] を選択すると、テストのリストを見つけることができます。project: 実際のプロジェクト ID。これらは、Google Cloud コンソールの [ようこそ] ページで確認できます。location: 利用可能なロケーションの一覧をご覧ください。

パラメータ

Python

run_name: このセッションの適切な実行名を指定します。experiment: このテストの名前またはインスタンス。Google Cloud コンソールで、セクション ナビゲーションの [テスト] を選択すると、テストのリストを見つけることができます。project: 実際のプロジェクト ID。これらは、Google Cloud コンソールの [ようこそ] ページで確認できます。location: 利用可能なロケーションの一覧をご覧ください。

時系列指標

Python

run_name: このセッションの適切な実行名を指定します。experiment: このテストの名前またはインスタンス。Google Cloud コンソールで、セクション ナビゲーションの [テスト] を選択すると、テストのリストを見つけることができます。project: 実際のプロジェクト ID。これらは、Google Cloud コンソールの [ようこそ] ページで確認できます。location: 利用可能なロケーションの一覧をご覧ください。

アーティファクト

Python

run_name: このセッションの適切な実行名を指定します。experiment: このテストの名前またはインスタンス。Google Cloud コンソールで、セクション ナビゲーションの [テスト] を選択すると、テストのリストを見つけることができます。project: 実際のプロジェクト ID。これらは、Google Cloud コンソールの [ようこそ] ページで確認できます。location: 利用可能なロケーションの一覧をご覧ください。

分類指標

Python

run_name: このセッションの適切な実行名を指定します。experiment: このテストの名前またはインスタンス。Google Cloud コンソールで、セクション ナビゲーションの [テスト] を選択すると、テストのリストを見つけることができます。project: 実際のプロジェクト ID。これらは、Google Cloud コンソールの [ようこそ] ページで確認できます。location: 利用可能なロケーションの一覧をご覧ください。

実行を比較する

Vertex AI SDK for Python を使用して、テストに関連付けられたデータを取得できます。テスト実行のデータは DataFrame で返されます。

実行を比較する

テスト実行のデータは DataFrame で返されます。

Python

experiment_name: テストの名前を指定します。Google Cloud コンソールで、セクション ナビゲーションの [テスト] を選択すると、テストのリストを見つけることができます。project: 実際のプロジェクト ID。これらの ID は、Google Cloud コンソールの [ようこそ] ページで確認できます。location: 利用可能なロケーションの一覧をご覧ください。

Google Cloud コンソール

Google Cloud コンソールを使用して、テスト実行の詳細を表示し、テスト実行を相互に比較します。

テスト実行データを表示する

- Google Cloud コンソールで、[テスト] ページに移動します。

<a{: class="button button-primary" l10n-attrs-original-order="href,target,class,track-name,track-type" l10n-encrypted-href="V3Ae1hvcBOij4KvUNiRrMltigmNHgUGOXn/QVSGplOhBlpxunv8WHL3F/z3VuS9rwbZOYpOQCXa+v4aZ0dt03w==" target="console" track-name="consoleLink" track-type="tasks" }="">[テスト] に移動

プロジェクトに関連付けられているテストのリストが表示されます。</a{:> - 確認する実行が含まれているテストを選択します。

実行のリスト、時系列データグラフ、指標とパラメータのデータテーブルが表示されます。このケースでは 3 つの実行が選択されていますが、時系列データグラフに表示されるのは 2 つの線のみです。3 番目のテスト実行には表示する時系列データがないため、3 行目は表示されません。

- 実行の名前をクリックして、詳細ページに移動します。

ナビゲーション バーと時系列データのグラフが表示されます。

- 選択した実行の指標、パラメータ、アーティファクト、詳細を表示するには、ナビゲーション バーのそれぞれのボタンをクリックします。

- 指標

- パラメータ

- アーティファクト

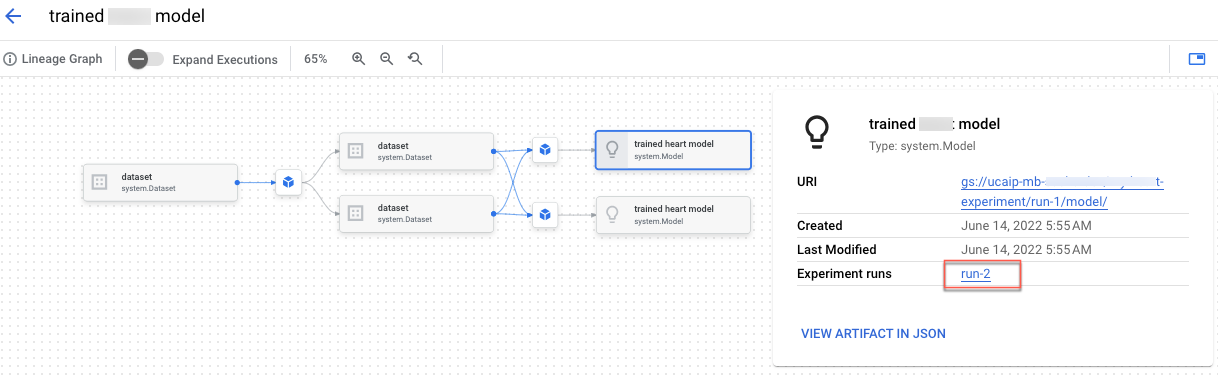

アーティファクト リネージを表示するには、[メタデータ ストアでアーティファクトを開く] リンクをクリックします。実行に関連付けられたリネージグラフが表示されます。

- 詳細

- 指標

他のユーザーとデータを共有するには、ビューに関連付けられた URL を使用します。たとえば、テストに関連付けられたテスト実行のリストを共有します。

テスト実行を比較する

実行を選択して、1 つのテスト内または複数のテスト間で比較できます。

- Google Cloud コンソールで、[テスト] ページに移動します。

<a{: class="button button-primary" l10n-attrs-original-order="href,target,class,track-name,track-type" l10n-encrypted-href="V3Ae1hvcBOij4KvUNiRrMltigmNHgUGOXn/QVSGplOhBlpxunv8WHL3F/z3VuS9rwbZOYpOQCXa+v4aZ0dt03w==" target="console" track-name="consoleLink" track-type="tasks" }="">[テスト] に移動

テストのリストが表示されます。</a{:> - 比較する実行を含むテストを選択します。実行のリストが表示されます。

- 比較するテスト実行を選択します。[比較] をクリックします。

デフォルトでは、選択したテスト実行の時系列指標を比較するグラフが表示されます。

- プロジェクト内のテストから別の実行を追加するには、[実行を追加] をクリックします。

他のユーザーとデータを共有するには、ビューに関連付けられた URL を使用します。たとえば、時系列指標データの比較ビューを共有します。

実行のステータスを更新する方法については、テスト実行を作成して管理するをご覧ください。